Google breidt zijn kunstmatige intelligentie-infrastructuur agressief uit, onthult krachtige nieuwe chips en sluit een deal van meerdere miljarden dollars met Anthropic, terwijl het tegelijkertijd de dominantie van Nvidia op de AI-acceleratormarkt uitdaagt. De aankondigingen concentreren zich op de nieuwe Tensor Processing Unit (TPU) van de zevende generatie en uitgebreide opties voor Arm-gebaseerde Axion-processors, en weerspiegelen een verschuiving in de industrie naar het aanbieden van reeds getrainde AI-modellen aan miljarden gebruikers, in plaats van ze alleen maar te trainen.

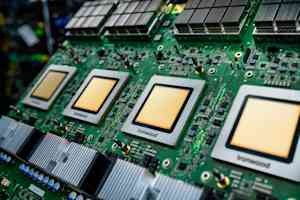

De nieuwste chip van Google: Ironwood

De kern van deze uitbreiding wordt gevormd door de Ironwood-chip, de nieuwste aangepaste AI-accelerator van Google. Het beschikt over meer dan vier keer de prestaties van zijn voorganger voor zowel trainings- als gevolgtrekkingswerklasten. Eén enkele ‘pod’ van Ironwood-chips kan tot 9.216 chips verbinden via Google’s eigen Inter-Chip Interconnect, waardoor een supercomputer ontstaat die 1,77 petabytes aan High Bandwidth Memory kan delen – ongeveer gelijk aan 40.000 Blu-ray-films. Belangrijke kenmerken zijn onder meer Optical Circuit Switching (OCS), dat dataverkeer automatisch omleidt rond storingen met minimale verstoring, en een co-designaanpak op systeemniveau die hardware en software samen optimaliseert.

De verbintenis van een miljard dollar van Anthropic

De belangrijkste bevestiging van de capaciteiten van Ironwood komt van Anthropic, het AI-veiligheidsbedrijf achter de Claude-modellenfamilie. Ze hebben toegezegd toegang te krijgen tot maximaal één miljoen TPU-chips, een deal die naar schatting tientallen miljarden dollars waard is – een van de grootste bekende cloudinfrastructuurverplichtingen in de geschiedenis. Deze investering zal Anthropic in staat stellen zijn computercapaciteit op te schalen en de snelheid en betrouwbaarheid te behouden die hun klanten verwachten.

Axion-processors: aanvulling op gespecialiseerde AI

Naast Ironwood introduceerde Google uitgebreide opties voor zijn Axion-processorfamilie, aangepaste Arm-gebaseerde CPU’s die zijn ontworpen voor algemene workloads die AI-applicaties ondersteunen. Het N4A-instancetype richt zich op microservices en andere workloads die cruciaal zijn voor AI-applicaties en levert tot 2x betere prijs-prestaties dan vergelijkbare x86 virtuele machines. Een nieuwe metalen C4A-instance biedt speciale fysieke servers voor gespecialiseerde workloads.

De AI-hypercomputer: software en integratie

Google benadrukt dat hardwareprestaties alleen onvoldoende zijn; het vereist geoptimaliseerde software. Ze bieden de ‘AI Hypercomputer’ aan, een geïntegreerd systeem dat rekenkracht, netwerken, opslag en software samenbrengt. Dit systeem heeft naar verluidt een rendement op de investering van 353% over drie jaar voor klanten opgeleverd. Belangrijke softwareverbeteringen zijn onder meer geavanceerd onderhoud voor TPU-clusters, open-source MaxText-framework-ondersteuning voor geavanceerde trainingstechnieken en een Inference Gateway die op intelligente wijze verzoeken verdeelt om de latentie en servicekosten te verminderen.

De infrastructuuruitdaging aanpakken: stroom en koeling

Google erkent de enorme uitdagingen op het gebied van de fysieke infrastructuur die deze uitbreiding met zich meebrengt. Ze implementeren een gelijkstroomvoeding van +/-400 volt die tot één megawatt per rack kan ondersteunen en dragen hun vijfde generatie koeldistributie-eenheidontwerp bij aan het Open Compute Project. Dit omvat onder meer het benutten van vloeistofkoeling, die 4.000 keer meer warmte kan transporteren dan lucht, wat cruciaal is voor steeds energie-intensievere AI-chips.

De dominantie van Nvidia uitdagen

De aankondigingen van Google vormen een gedurfde uitdaging voor de overweldigende dominantie van Nvidia (naar schatting 80-95% marktaandeel) op de AI-acceleratormarkt. Hoewel de ontwikkeling van silicium op maat aanzienlijke investeringen vergt en te maken krijgt met uitdagingen op het gebied van software-ecosystemen, stelt Google dat een nauwe integratie van modelonderzoek tot chipontwerp unieke optimalisaties mogelijk maakt.

Belangrijkste afhaalrestaurants

De nieuwste stappen van Google benadrukken een cruciale verschuiving in het AI-landschap, waarbij cloudproviders zich steeds meer richten op het efficiënt inzetten van getrainde AI-modellen op schaal. De nieuwe chips van het bedrijf, de enorme deal met Anthropic en de focus op geïntegreerde hardware en software zijn bedoeld om de concurrentiedynamiek van de AI-infrastructuurmarkt opnieuw vorm te geven en een haalbaar alternatief te bieden voor de GPU’s van Nvidia. Het vermogen van de industrie om dit investeringsniveau op peil te houden en het tempo van de architectonische innovatie zullen de komende maanden van cruciaal belang zijn om in de gaten te houden.