O Google está expandindo agressivamente sua infraestrutura de inteligência artificial, revelando novos chips poderosos e garantindo um acordo multibilionário com a Anthropic, ao mesmo tempo em que desafia o domínio da Nvidia no mercado de aceleradores de IA. Os anúncios centram-se na nova Unidade de Processamento Tensor (TPU) de sétima geração e nas opções expandidas para processadores Axion baseados em Arm, refletindo uma mudança na indústria no sentido de servir modelos de IA já treinados a milhares de milhões de utilizadores, em vez de apenas treiná-los.

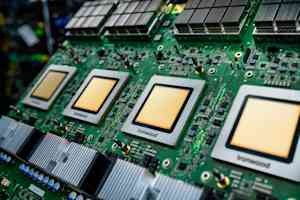

O mais novo chip do Google: Ironwood

No centro dessa expansão está o chip Ironwood, o mais recente acelerador de IA personalizado do Google. Ele possui quatro vezes o desempenho de seu antecessor para cargas de trabalho de treinamento e inferência. Um único “pod” de chips Ironwood pode conectar até 9.216 chips por meio do Inter-Chip Interconnect proprietário do Google, criando um supercomputador capaz de compartilhar 1,77 petabytes de memória de alta largura de banda – aproximadamente o equivalente a 40.000 filmes Blu-ray. Os principais recursos incluem Optical Circuit Switching (OCS), que redireciona automaticamente o tráfego de dados em torno de falhas com interrupção mínima, e uma abordagem de co-design em nível de sistema que otimiza hardware e software juntos.

Compromisso de bilhões de dólares da Anthropic

A validação mais significativa das capacidades do Ironwood vem da Anthropic, a empresa de segurança de IA por trás da família de modelos Claude. Eles se comprometeram a acessar até um milhão de chips TPU, um acordo estimado em dezenas de bilhões de dólares – um dos maiores compromissos de infraestrutura em nuvem conhecidos na história. Este investimento permitirá à Anthropic dimensionar sua capacidade computacional e manter a velocidade e a confiabilidade que seus clientes esperam.

Processadores Axion: complementando a IA especializada

Juntamente com o Ironwood, o Google introduziu opções expandidas para sua família de processadores Axion, CPUs personalizadas baseadas em Arm projetadas para cargas de trabalho de uso geral que suportam aplicativos de IA. O tipo de instância N4A é direcionado a microsserviços e outras cargas de trabalho críticas para aplicativos de IA, oferecendo desempenho de preço até duas vezes melhor do que máquinas virtuais x86 comparáveis. Uma nova instância metálica C4A fornece servidores físicos dedicados para cargas de trabalho especializadas.

O hipercomputador AI: software e integração

O Google enfatiza que o desempenho do hardware por si só é insuficiente; requer software otimizado. Eles estão oferecendo o “AI Hypercomputer”, um sistema integrado que reúne computação, rede, armazenamento e software. Este sistema supostamente proporcionou um retorno sobre o investimento de 353% em três anos para os clientes. Os principais aprimoramentos de software incluem manutenção avançada para clusters de TPU, suporte de estrutura MaxText de código aberto para técnicas avançadas de treinamento e um gateway de inferência que equilibra a carga de maneira inteligente para reduzir a latência e os custos de serviço.

Enfrentando o Desafio da Infraestrutura: Energia e Refrigeração

O Google reconhece os enormes desafios de infraestrutura física impostos por esta expansão. Eles estão implementando fornecimento de energia de corrente contínua de +/- 400 volts capaz de suportar até um megawatt por rack e contribuindo com seu projeto de unidade de distribuição de resfriamento de quinta geração para o Open Compute Project. Isso inclui o aproveitamento do resfriamento líquido, que pode transportar 4.000 vezes mais calor que o ar, crucial para chips de IA que consomem cada vez mais energia.

Desafiando o domínio da Nvidia

Os anúncios do Google representam um desafio ousado ao domínio esmagador da Nvidia (estimativa de 80-95% de participação de mercado) no mercado de aceleradores de IA. Embora o desenvolvimento de silício personalizado exija investimentos significativos e enfrente desafios do ecossistema de software, o Google argumenta que a forte integração da pesquisa de modelos ao design de chips permite otimizações exclusivas.

Principais conclusões

As últimas ações do Google destacam uma mudança crucial no cenário da IA, com os provedores de nuvem cada vez mais focados na implantação eficiente de modelos de IA treinados em escala. Os novos chips da empresa, o grande acordo com a Anthropic e o foco em hardware e software integrados visam remodelar a dinâmica competitiva do mercado de infraestrutura de IA e fornecer uma alternativa viável às GPUs da Nvidia. A capacidade da indústria de sustentar este nível de investimento e o ritmo da inovação arquitetônica serão fundamentais para observar nos próximos meses.