Google agresywnie rozbudowuje swoją infrastrukturę sztucznej inteligencji, przedstawiając nowe, potężne chipy i podpisując wielomiliardowy kontrakt z Anthropic, kwestionując jednocześnie dominację Nvidii na rynku akceleratorów AI. Ogłoszenia skupiają się wokół nowego chipa Tensor Processing Unit (TPU) siódmej generacji i rozszerzonych opcji dla procesorów Axion opartych na architekturze ARM, odzwierciedlając zwrot w branży w stronę wydajnego wdrażania już wytrenowanych modeli sztucznej inteligencji dla miliardów użytkowników, a nie tylko ich szkolenia.

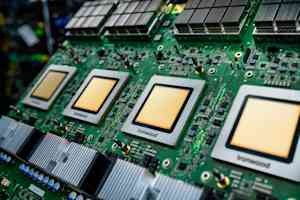

Nowy chip Google: Ironwood

Sercem tego rozszerzenia jest chip Ironwood, najnowszy dedykowany akcelerator sztucznej inteligencji firmy Google. Zapewnia ponad czterokrotnie większą wydajność w porównaniu do swojego poprzednika, zarówno w zakresie uczenia, jak i wnioskowania. Pojedynczy „skład” chipów Ironwood może połączyć do 9216 chipów za pośrednictwem opatentowanego przez Google połączenia Inter-Chip Interconnect, tworząc superkomputer zdolny do współużytkowania 1,77 petabajtów pamięci o dużej przepustowości – co odpowiada w przybliżeniu 40 000 filmów Blu-ray. Kluczowe funkcje obejmują przełączanie obwodów optycznych (OCS), które automatycznie przekierowuje ruch danych wokół usterek przy minimalnych zakłóceniach, a także podejście do wspólnego projektowania skoncentrowane na systemie, które wspólnie optymalizuje sprzęt i oprogramowanie.

Miliardowe zaangażowanie firmy Anthropic

Najbardziej znaczącym potwierdzeniem możliwości Ironwood było zaangażowanie Anthropic, firmy specjalizującej się w bezpieczeństwie AI i twórcy rodziny modeli Claude. Zobowiązują się uzyskać dostęp do miliona chipów TPU w ramach szacunkowej transakcji wartej dziesiątki miliardów dolarów – jednej z największych znanych transakcji na infrastrukturę chmurową w historii. Inwestycja ta pozwoli firmie Anthropic skalować swoje możliwości obliczeniowe oraz utrzymać szybkość i niezawodność, jakiej oczekują klienci.

Procesory Axion: uzupełnienie wyspecjalizowanej sztucznej inteligencji

Dzięki Ironwood firma Google wprowadziła rozszerzone opcje dla swojej linii procesorów Axion, niestandardowych procesorów opartych na architekturze ARM, przeznaczonych do ogólnych zadań i obsługujących aplikacje AI. Typ instancji N4A jest przeznaczony do mikrousług i innych zadań krytycznych dla aplikacji AI, zapewniając wydajność nawet 2X lepszą niż porównywalne maszyny wirtualne x86. Nowa metalowa instancja C4A zapewnia dedykowane serwery fizyczne do specjalistycznych obciążeń.

Hiperkomputer AI: oprogramowanie i integracja

Google podkreśla, że sam sprzęt nie wystarczy; potrzebne są zoptymalizowane rozwiązania programowe. Oferują „hiperkomputer AI”, zintegrowany system łączący przetwarzanie, sieć, pamięć masową i oprogramowanie. Według doniesień system zapewnił klientom zwrot z inwestycji na poziomie 353% w ciągu trzech lat. Kluczowe ulepszenia oprogramowania obejmują ulepszoną obsługę klastrów TPU, obsługę platformy MaxText typu open source dla zaawansowanych technik szkoleniowych oraz usługę Inference Gateway, która inteligentnie równoważy żądania w celu zmniejszenia opóźnień i kosztów konserwacji.

Rozwiązanie problemu infrastruktury: zasilanie i chłodzenie

Google zdaje sobie sprawę z ogromnych wyzwań związanych z infrastrukturą fizyczną związanych z tą rozbudową. Wprowadzają zasilanie +/-400 V prądu stałego, które może obsłużyć do 1 megawata na szafę, i przyczyniają się do piątej generacji projektu węzła dystrybucji chłodzenia w ramach Open Compute Project. Obejmuje to zastosowanie chłodzenia cieczą, które może transportować 4000 razy więcej ciepła niż powietrze, co ma kluczowe znaczenie w przypadku coraz bardziej energochłonnych chipów AI.

Rzucanie wyzwania dominacji Nvidii

Oświadczenie Google stanowi śmiałe wyzwanie dla dominacji Nvidii (szacowanej na 80-95% udziału w rynku) na rynku akceleratorów AI. Chociaż opracowywanie niestandardowych chipów wymaga znacznych inwestycji i wiąże się z wyzwaniami ekosystemu oprogramowania, Google twierdzi, że ścisła integracja od badań modelowych po projektowanie chipów pozwala na unikalne optymalizacje.

Kluczowe wnioski

Najnowsze posunięcia Google podkreślają ważną zmianę w krajobrazie sztucznej inteligencji, a dostawcy usług w chmurze w coraz większym stopniu skupiają się na skutecznym wdrażaniu wytrenowanych modeli sztucznej inteligencji na dużą skalę. Nowe chipy firmy, masowa umowa z Anthropic oraz skupienie się na zintegrowanym sprzęcie i oprogramowaniu mogą zmienić dynamikę konkurencji na rynku infrastruktury AI i zapewnić realną alternatywę dla procesorów graficznych Nvidia. W nadchodzących miesiącach kluczowa będzie zdolność branży do utrzymania obecnego poziomu inwestycji i tempa innowacji architektonicznych.