Google étend de manière agressive son infrastructure d’intelligence artificielle, dévoile de nouvelles puces puissantes et conclut un accord de plusieurs milliards de dollars avec Anthropic, tout en remettant en question la domination de Nvidia sur le marché des accélérateurs d’IA. Les annonces se concentrent sur la nouvelle unité de traitement Tensor (TPU) de septième génération et sur les options étendues pour les processeurs Axion basés sur Arm, reflétant une évolution de l’industrie vers la fourniture de modèles d’IA déjà formés à des milliards d’utilisateurs, plutôt que de les former uniquement.

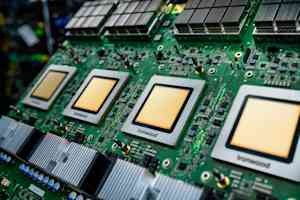

La nouvelle puce de Google : Ironwood

Au cœur de cette extension se trouve la puce Ironwood, le dernier accélérateur d’IA personnalisé de Google. Il offre des performances quatre fois supérieures à celles de son prédécesseur pour les charges de travail de formation et d’inférence. Un seul « pod » de puces Ironwood peut connecter jusqu’à 9 216 puces via l’interconnexion propriétaire Inter-Chip de Google, créant ainsi un superordinateur capable de partager 1,77 pétaoctets de mémoire à large bande passante, soit à peu près l’équivalent de 40 000 films Blu-ray. Les fonctionnalités clés incluent la commutation de circuits optiques (OCS), qui redirige automatiquement le trafic de données autour des pannes avec un minimum de perturbations, et une approche de co-conception au niveau du système qui optimise ensemble le matériel et les logiciels.

L’engagement d’Anthropic pour un milliard de dollars

La validation la plus significative des capacités d’Ironwood vient d’Anthropic, la société de sécurité IA derrière la famille de modèles Claude. Ils se sont engagés à accéder à jusqu’à un million de puces TPU, un accord estimé à plusieurs dizaines de milliards de dollars, l’un des plus grands engagements connus en matière d’infrastructure cloud dans l’histoire. Cet investissement permettra à Anthropic d’augmenter sa capacité de calcul et de maintenir la vitesse et la fiabilité attendues par ses clients.

Processeurs Axion : en complément de l’IA spécialisée

Aux côtés d’Ironwood, Google a introduit des options étendues pour sa famille de processeurs Axion, des processeurs personnalisés basés sur Arm conçus pour les charges de travail à usage général prenant en charge les applications d’IA. Le type d’instance N4A cible les microservices et autres charges de travail critiques pour les applications d’IA, offrant un rapport prix/performances jusqu’à 2 fois supérieur à celui des machines virtuelles x86 comparables. Une nouvelle instance métallique C4A fournit des serveurs physiques dédiés pour les charges de travail spécialisées.

L’hyperordinateur IA : logiciels et intégration

Google souligne que les performances matérielles à elles seules sont insuffisantes ; cela nécessite un logiciel optimisé. Ils proposent « AI Hypercomputer », un système intégré réunissant le calcul, la mise en réseau, le stockage et les logiciels. Ce système aurait généré un retour sur investissement de 353 % sur trois ans pour les clients. Les principales améliorations logicielles incluent une maintenance avancée pour les clusters TPU, la prise en charge du framework MaxText open source pour les techniques de formation avancées et une passerelle d’inférence qui équilibre intelligemment la charge des demandes afin de réduire la latence et les coûts de service.

Relever le défi des infrastructures : électricité et refroidissement

Google reconnaît les énormes défis d’infrastructure physique posés par cette expansion. Ils mettent en œuvre une alimentation en courant continu de +/-400 volts capable de prendre en charge jusqu’à un mégawatt par rack et contribuent à la conception de leur unité de distribution de refroidissement de cinquième génération au projet Open Compute. Cela inclut l’exploitation du refroidissement liquide, qui peut transporter 4 000 fois plus de chaleur que l’air, ce qui est crucial pour les puces d’IA de plus en plus gourmandes en énergie.

Remettre en question la domination de Nvidia

Les annonces de Google représentent un défi audacieux à la domination écrasante de Nvidia (part de marché estimée à 80-95 %) sur le marché des accélérateurs d’IA. Alors que le développement de silicium personnalisé nécessite des investissements importants et se heurte à des défis liés à l’écosystème logiciel, Google affirme qu’une intégration étroite de la recherche de modèles à la conception de puces permet des optimisations uniques.

Points clés à retenir

Les dernières initiatives de Google mettent en évidence un changement crucial dans le paysage de l’IA, les fournisseurs de cloud computing se concentrant de plus en plus sur le déploiement efficace de modèles d’IA formés à grande échelle. Les nouvelles puces de la société, l’accord massif avec Anthropic et l’accent mis sur le matériel et les logiciels intégrés visent à remodeler la dynamique concurrentielle du marché des infrastructures d’IA et à fournir une alternative viable aux GPU de Nvidia. La capacité de l’industrie à maintenir ce niveau d’investissement et le rythme de l’innovation architecturale seront essentiels à surveiller dans les mois à venir.