Google está expandiendo agresivamente su infraestructura de inteligencia artificial, presentando nuevos y potentes chips y asegurando un acuerdo multimillonario con Anthropic, al mismo tiempo que desafía el dominio de Nvidia en el mercado de aceleradores de IA. Los anuncios se centran en la nueva Unidad de Procesamiento Tensorial (TPU) de séptima generación y opciones ampliadas para los procesadores Axion basados en Arm, lo que refleja un cambio en la industria hacia servir modelos de IA ya entrenados a miles de millones de usuarios, en lugar de entrenarlos únicamente.

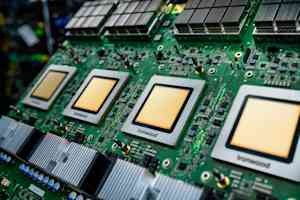

El chip más nuevo de Google: Ironwood

En el centro de esta expansión se encuentra el chip Ironwood, el último acelerador de IA personalizado de Google. Cuenta con un rendimiento cuatro veces mayor que su predecesor tanto para cargas de trabajo de entrenamiento como de inferencia. Una sola “cápsula” de chips Ironwood puede conectar hasta 9.216 chips a través de la interconexión entre chips patentada de Google, creando una supercomputadora capaz de compartir 1,77 petabytes de memoria de alto ancho de banda, aproximadamente el equivalente a 40.000 películas Blu-ray. Las características clave incluyen conmutación de circuitos ópticos (OCS), que redirige automáticamente el tráfico de datos alrededor de fallas con una interrupción mínima, y un enfoque de codiseño a nivel de sistema que optimiza el hardware y el software juntos.

El compromiso de miles de millones de dólares de Anthropic

La validación más importante de las capacidades de Ironwood proviene de Anthropic, la empresa de seguridad de IA detrás de la familia de modelos Claude. Se han comprometido a acceder a hasta un millón de chips de TPU, un acuerdo cuyo valor se estima en decenas de miles de millones de dólares, uno de los mayores compromisos de infraestructura de nube conocidos en la historia. Esta inversión permitirá a Anthropic escalar su capacidad informática y mantener la velocidad y confiabilidad que esperan sus clientes.

Procesadores Axion: complementando la IA especializada

Además de Ironwood, Google presentó opciones ampliadas para su familia de procesadores Axion, CPU personalizadas basadas en Arm diseñadas para cargas de trabajo de uso general que admiten aplicaciones de inteligencia artificial. El tipo de instancia N4A se dirige a microservicios y otras cargas de trabajo críticas para las aplicaciones de IA, ofreciendo una relación precio-rendimiento hasta 2 veces mejor que las máquinas virtuales x86 comparables. Una nueva instancia metálica C4A proporciona servidores físicos dedicados para cargas de trabajo especializadas.

La hipercomputadora de IA: software e integración

Google enfatiza que el rendimiento del hardware por sí solo es insuficiente; Requiere software optimizado. Están ofreciendo la “Hipercomputadora AI”, un sistema integrado que reúne computación, redes, almacenamiento y software. Según se informa, este sistema ha generado un retorno de la inversión del 353% en tres años para los clientes. Las mejoras clave del software incluyen mantenimiento avanzado para clústeres de TPU, compatibilidad con el marco MaxText de código abierto para técnicas de capacitación avanzadas y una puerta de enlace de inferencia que equilibra de forma inteligente las solicitudes para reducir la latencia y los costos de servicio.

Afrontar el desafío de la infraestructura: energía y refrigeración

Google reconoce los enormes desafíos de infraestructura física que plantea esta expansión. Están implementando un suministro de energía de corriente continua de +/-400 voltios capaz de soportar hasta un megavatio por rack y contribuyendo con su diseño de unidad de distribución de enfriamiento de quinta generación al Open Compute Project. Esto incluye aprovechar la refrigeración líquida, que puede transportar 4.000 veces más calor que el aire, algo crucial para los chips de IA que consumen cada vez más energía.

Desafiando el dominio de Nvidia

Los anuncios de Google representan un desafío audaz al abrumador dominio de Nvidia (cuota de mercado estimada entre el 80% y el 95%) en el mercado de aceleradores de IA. Si bien el desarrollo de silicio personalizado requiere una inversión significativa y enfrenta desafíos en el ecosistema de software, Google sostiene que la estrecha integración desde la investigación de modelos hasta el diseño de chips permite optimizaciones únicas.

Conclusiones clave

Las últimas medidas de Google ponen de relieve un cambio crucial en el panorama de la IA, en el que los proveedores de la nube se centran cada vez más en implementar de forma eficiente modelos de IA entrenados a escala. Los nuevos chips de la compañía, el acuerdo masivo con Anthropic y el enfoque en hardware y software integrados tienen como objetivo remodelar la dinámica competitiva del mercado de infraestructura de IA y proporcionar una alternativa viable a las GPU de Nvidia. Será fundamental observar en los próximos meses la capacidad de la industria para mantener este nivel de inversión y el ritmo de la innovación arquitectónica.