Google baut seine Infrastruktur für künstliche Intelligenz aggressiv aus, stellt leistungsstarke neue Chips vor und sichert sich einen milliardenschweren Deal mit Anthropic, während es gleichzeitig Nvidias Dominanz auf dem Markt für KI-Beschleuniger herausfordert. Im Mittelpunkt der Ankündigungen stehen die neue Tensor Processing Unit (TPU) der siebten Generation und erweiterte Optionen für Arm-basierte Axion-Prozessoren. Dies spiegelt einen Wandel in der Branche wider, Milliarden von Benutzern bereits trainierte KI-Modelle bereitzustellen, anstatt sie nur zu trainieren.

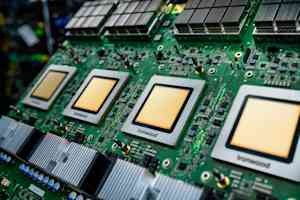

Googles neuester Chip: Ironwood

Das Herzstück dieser Erweiterung ist der Ironwood-Chip, Googles neuester benutzerdefinierter KI-Beschleuniger. Es bietet mehr als das Vierfache der Leistung seines Vorgängers sowohl bei Trainings- als auch bei Inferenz-Workloads. Ein einzelner „Pod“ von Ironwood-Chips kann bis zu 9.216 Chips über Googles proprietäres Inter-Chip Interconnect verbinden und so einen Supercomputer schaffen, der 1,77 Petabyte High-Bandwidth-Speicher gemeinsam nutzen kann – was ungefähr 40.000 Blu-ray-Filmen entspricht. Zu den wichtigsten Funktionen gehören Optical Circuit Switching (OCS), das den Datenverkehr bei Ausfällen automatisch und mit minimaler Unterbrechung umleitet, und ein Co-Design-Ansatz auf Systemebene, der Hardware und Software gemeinsam optimiert.

Anthropics milliardenschweres Engagement

Die bedeutendste Bestätigung der Fähigkeiten von Ironwood kommt von Anthropic, dem KI-Sicherheitsunternehmen hinter der Claude-Modellfamilie. Sie haben sich verpflichtet, auf bis zu eine Million TPU-Chips zuzugreifen, ein Deal, der schätzungsweise mehrere zehn Milliarden Dollar wert ist – einer der größten bekannten Cloud-Infrastruktur-Zusagen in der Geschichte. Diese Investition wird es Anthropic ermöglichen, seine Rechenkapazität zu skalieren und die Geschwindigkeit und Zuverlässigkeit aufrechtzuerhalten, die seine Kunden erwarten.

Axion-Prozessoren: Ergänzung zur spezialisierten KI

Neben Ironwood stellte Google erweiterte Optionen für seine Axion-Prozessorfamilie vor, maßgeschneiderte Arm-basierte CPUs, die für allgemeine Arbeitslasten zur Unterstützung von KI-Anwendungen entwickelt wurden. Der N4A-Instanztyp zielt auf Microservices und andere für KI-Anwendungen kritische Workloads ab und bietet ein bis zu doppelt so gutes Preis-Leistungs-Verhältnis als vergleichbare x86-VMs. Eine neue C4A-Metallinstanz stellt dedizierte physische Server für spezielle Workloads bereit.

Der KI-Hypercomputer: Software und Integration

Google betont, dass die Hardware-Leistung allein nicht ausreiche; es erfordert optimierte Software. Sie bieten den „KI-Hypercomputer“ an, ein integriertes System, das Rechenleistung, Netzwerk, Speicher und Software vereint. Berichten zufolge hat dieses System den Kunden innerhalb von drei Jahren eine Investitionsrendite von 353 % beschert. Zu den wichtigsten Softwareverbesserungen gehören erweiterte Wartung für TPU-Cluster, Unterstützung des Open-Source-MaxText-Frameworks für erweiterte Trainingstechniken und ein Inferenz-Gateway, das Anfragen intelligent verteilt, um Latenz und Bereitstellungskosten zu reduzieren.

Bewältigung der Infrastrukturherausforderung: Stromversorgung und Kühlung

Google ist sich der enormen Herausforderungen für die physische Infrastruktur bewusst, die diese Erweiterung mit sich bringt. Sie implementieren eine Gleichstromversorgung mit +/-400 Volt, die bis zu ein Megawatt pro Rack unterstützen kann, und tragen ihr Design der Kühlverteilungseinheit der fünften Generation zum Open Compute Project bei. Dazu gehört die Nutzung von Flüssigkeitskühlung, die 4.000-mal mehr Wärme als Luft transportieren kann, was für immer energieintensivere KI-Chips von entscheidender Bedeutung ist.

Nvidias Dominanz herausfordern

Die Ankündigungen von Google stellen eine mutige Herausforderung für Nvidias überwältigende Dominanz (geschätzter Marktanteil von 80–95 %) auf dem Markt für KI-Beschleuniger dar. Während die kundenspezifische Siliziumentwicklung erhebliche Investitionen erfordert und mit Herausforderungen für das Software-Ökosystem konfrontiert ist, argumentiert Google, dass eine enge Integration von der Modellforschung bis zum Chipdesign einzigartige Optimierungen ermöglicht.

Wichtige Erkenntnisse

Die jüngsten Schritte von Google verdeutlichen einen entscheidenden Wandel in der KI-Landschaft, da sich Cloud-Anbieter zunehmend auf die effiziente Bereitstellung geschulter KI-Modelle in großem Maßstab konzentrieren. Die neuen Chips des Unternehmens, der massive Deal mit Anthropic und der Fokus auf integrierte Hardware und Software zielen darauf ab, die Wettbewerbsdynamik des KI-Infrastrukturmarktes neu zu gestalten und eine praktikable Alternative zu Nvidias GPUs zu bieten. Die Fähigkeit der Branche, dieses Investitionsniveau aufrechtzuerhalten, und das Tempo architektonischer Innovationen werden in den kommenden Monaten von entscheidender Bedeutung sein.